Meta Learning recipe, black-box adaptation, optimization based approaches

Table of Contents

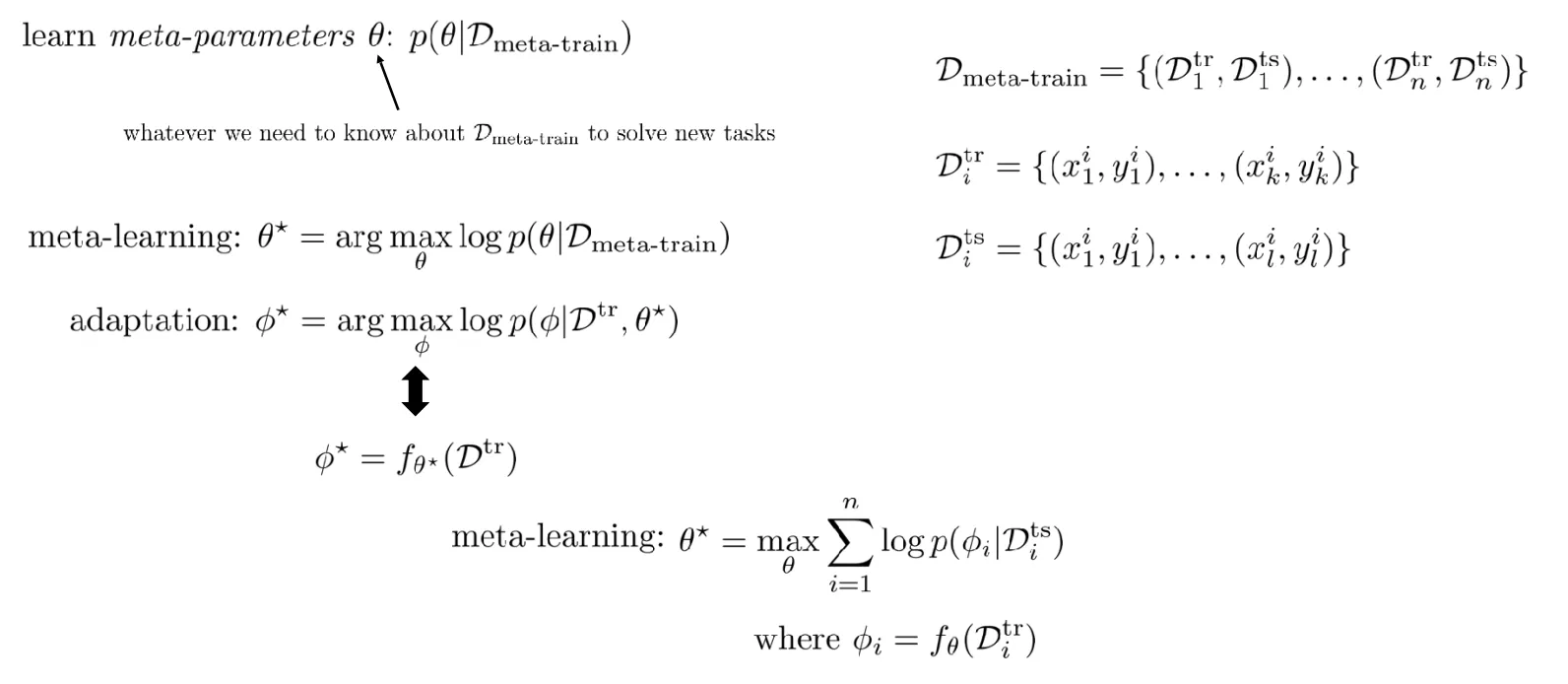

Probabilistic formulation of meta-learning(recap)

General recipe of meta-learning algorithms

Black-box adaptation approaches

Optimization-based meta-learning

Probabilistic formulation of meta-learning (recap)

General recipe of meta learning algorithms

많이 사용하는 dataset으로는 Omniglot, Mini-Imagenet, CIFAR, CUB, CelebA 등이 있다.

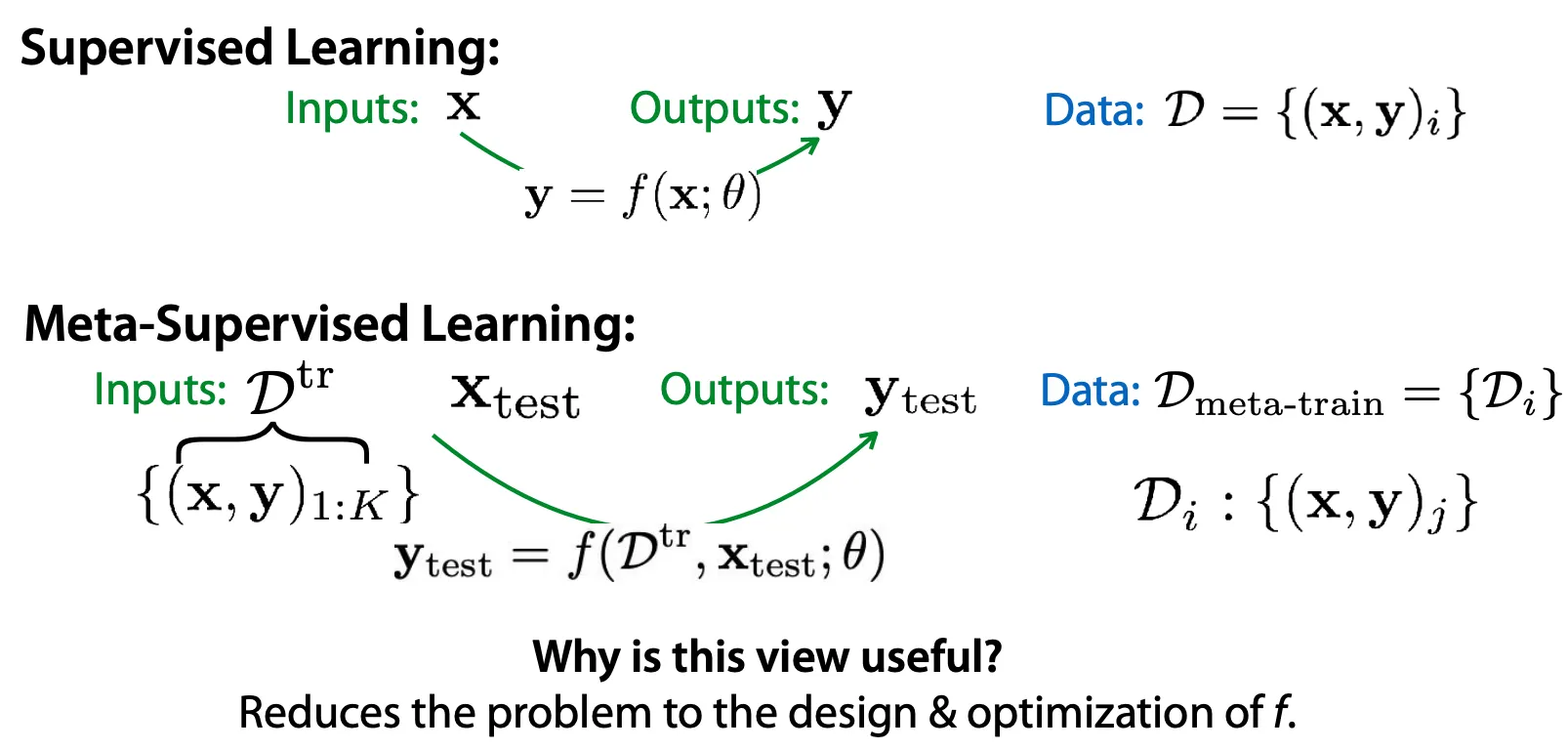

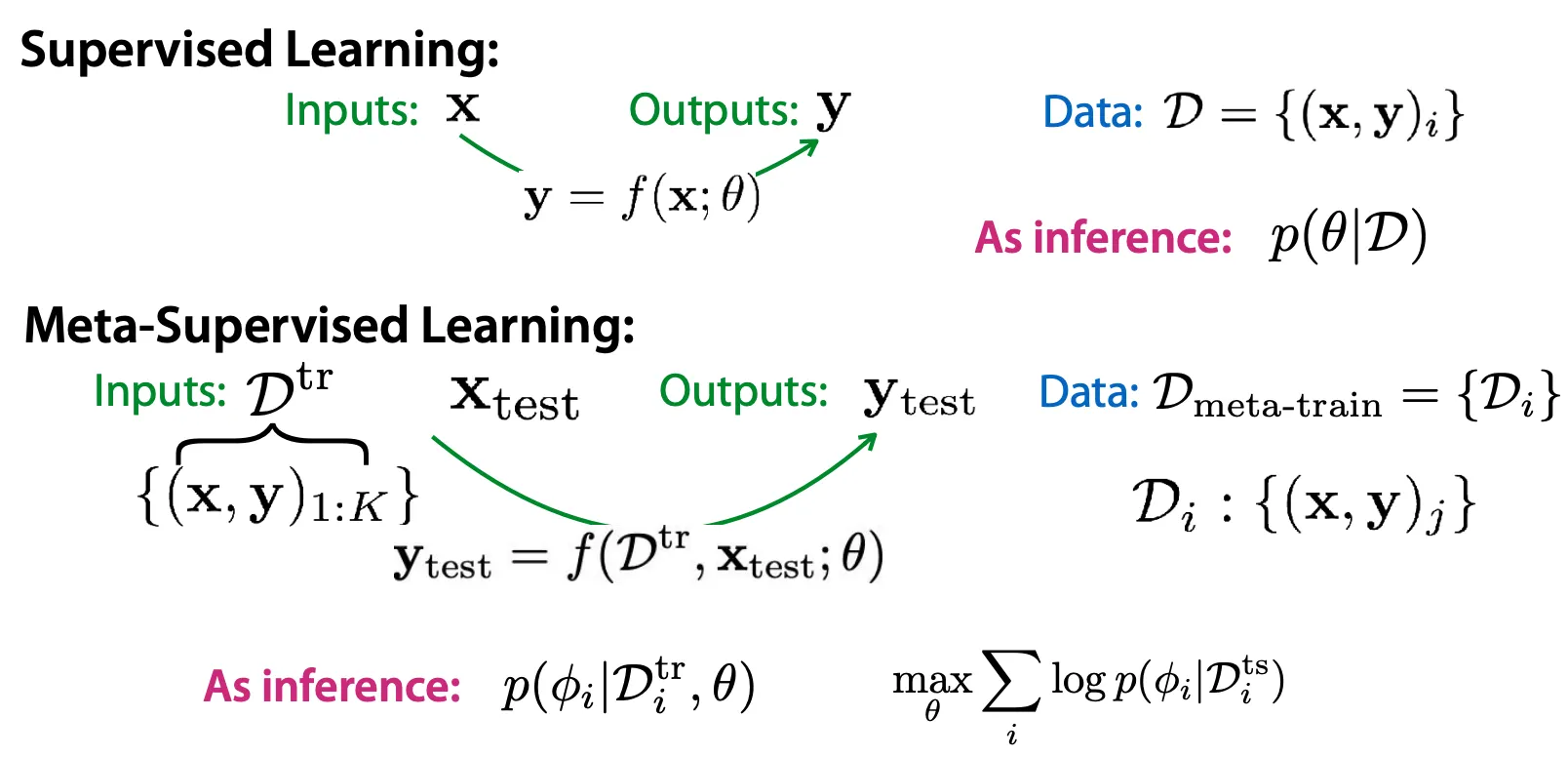

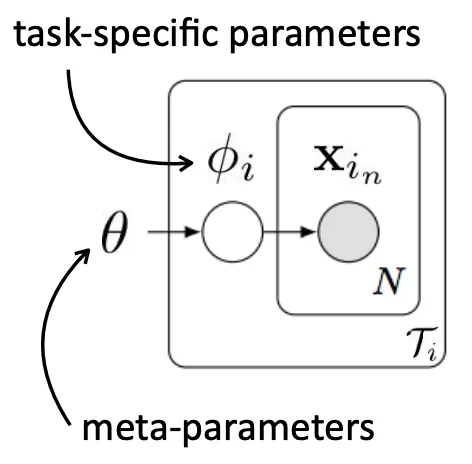

Mechanistic view

Probabilistic view

General recipe - Meta learning algorithm을 design 하는 방법

1.

의 형태를 결정한다.

2.

를 maximum likelihood objective 관점에서 을 이용해 어떻게 optimize할지 결정한다.

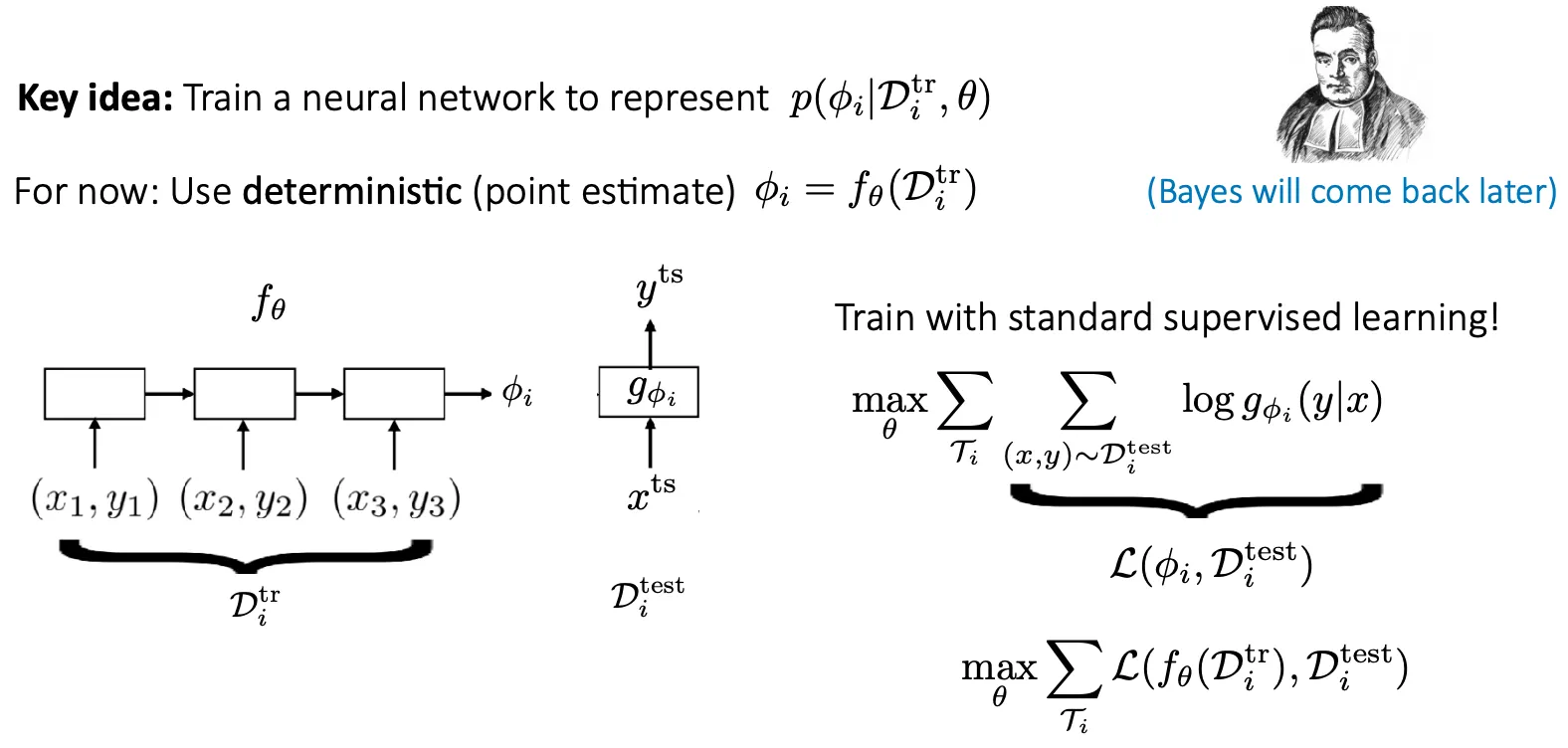

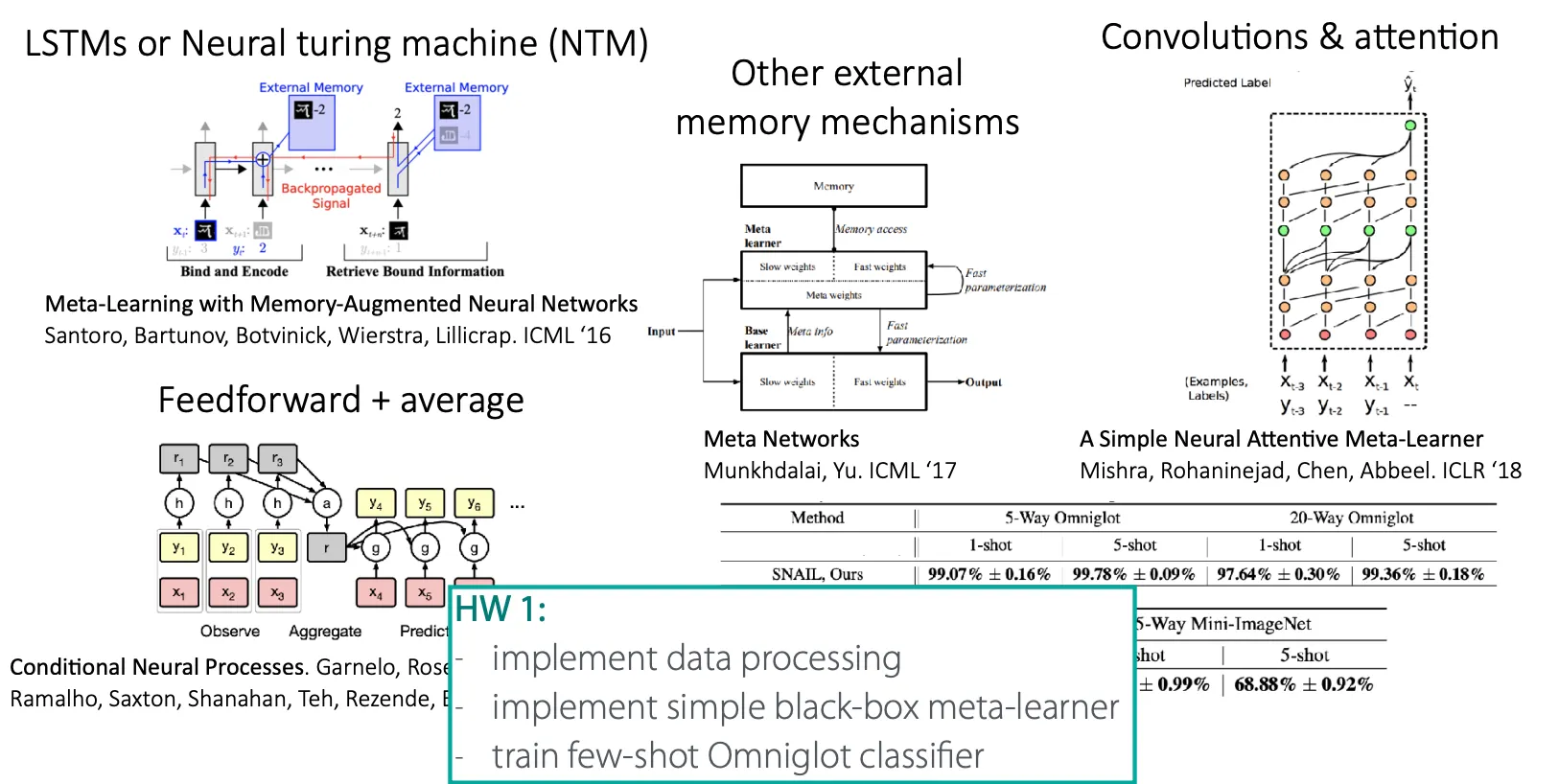

Black-box adaptation

위와 같이 neural network의 parameter를 계속 update 하는 것이 black-box adaptation이다.

하지만 neural network의 parameter를 그대로 output하는 것은 scalability가 떨어지므로, 그 task의 contextual information을 represent할 수 있는 low dimensional vector 만 output 하는 방법도 있다. (Santoro et al. MANN, Mishra et al. SNAIL)

Black box adaptation의 예시

Black box adaptation의 장단점

장점

•

Expressive (직관적으로 이해 빠름)

•

다른 learning problem (RL 등)과 쉽게 연결 가능

단점

•

model과 task가 complex

•

data가 굉장히 많이 필요

다른 방법은 없을까? → optimization-based approach!

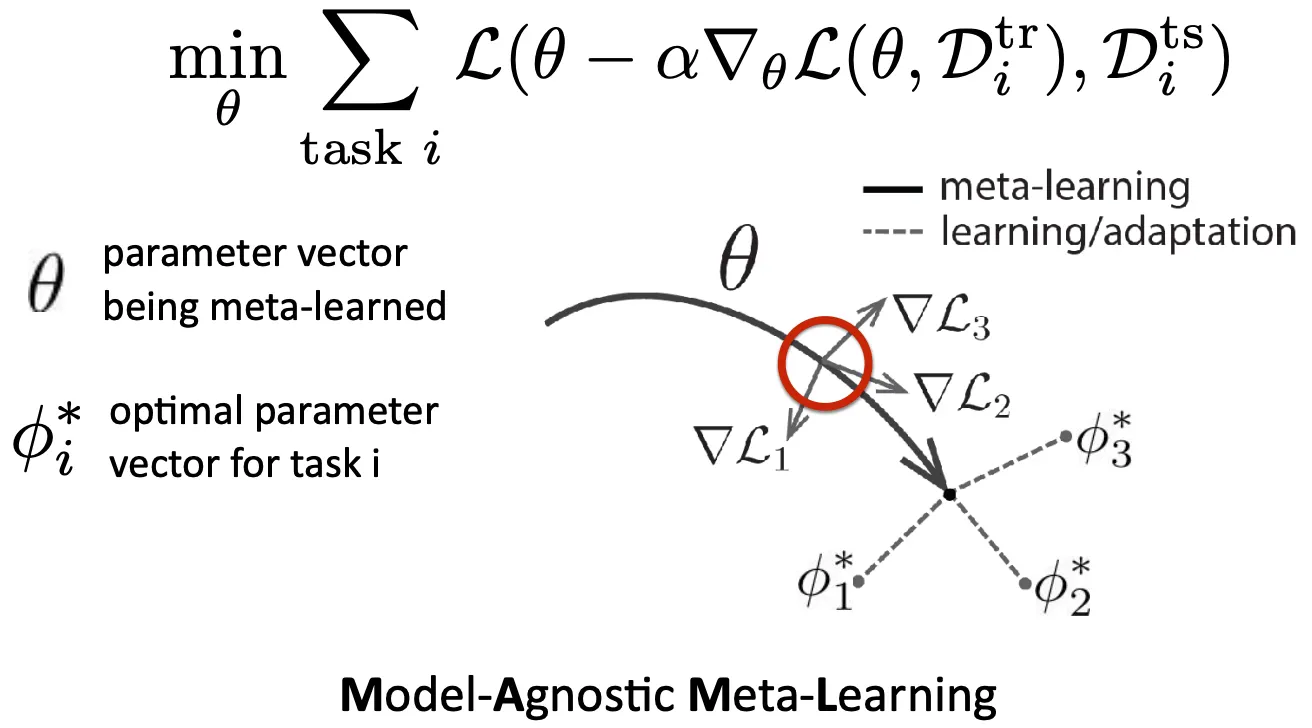

Optimization-based inference

Key idea: 를 optimization을 통해서 얻자.

이 때, 는 prior로 작용하는데, 보통 fine tuning을 위한 initialization의 형태로 부여해준다.

MAML도 여러 challenge가 있다.

•

inner gradient step에 효과적인 architecture를 어떻게 선택해서 찾아낼까?

→ progressive neural architecture search + MAML을 한 Auto-Meta(Kim et al.) 논문 참고

•

Bi-level optimization은 stability가 부족할 수 있다.

→ learning rate와 context variable 등의 아이디어 적용

•

2nd order derivative는 compute & memory-intensive 하다.

→ 1st order로 근사해도 큰 차이 없다.

MAML의 장단점

장점

•

Meta learning에서 positive inductive bias 제공

•

절차가 consistent해서 extrapolation에도 잘 적용

•

충분히 깊은 네트워크를 사용했을 때 expressive power가 크다.

•

model-agnositc

단점

•

2nd order derivative 가 필요하다

•

compute & memory intensive