1. Microsoft에서 제공하는 생성 툴

•

An instagram post that provides the information we will sell a Baguette from 2023-May. Must contain the image of Baguette. Prefer cozy and warm mood.

•

공대생 입장에서는 훌륭한 디자인 초안 제공

•

미대 입장에서는… Figma랑 같이 활용하면 좋을듯!

•

생각보다 시간이 너무 오래 걸림

•

koala making a free throw in basketball game

2. 서비스형 생성 AI

•

미드저니

◦

사실적인 이미지를 원하면 추천

•

니지저니

◦

애니메이션 풍의 이미지 생성에 특화

•

노벨 AI

◦

스테이블 디퓨전 기반으로 다양한 이미지 생성

3. 설치형 생성 AI

•

본인의 컴퓨터에 있는 그래픽 카드의 RAM이 10GB가 넘을 때 가능

•

최소 20 시리즈 이상, 현실적으로는 30 시리즈 이상

•

•

Google colab으로도 가능

4. LoRA

•

arXiv:2106.09685

•

LoRA(Low-rank Adaption for Fast Text-to-Image Diffusion Fine-tuning)

•

https://arxiv.org/abs/2106.09685

•

Hypernetwork, Textual Inversion (TI = Embedding) 같은 스테이블 디퓨젼의 파인튜닝 방식 중 하나로 기존 모델(pretrained-model weights)을 건들이지 않고(freeze) 레이어 사이에 새로운 레이어를 추가(inject)하는 형태로 학습하는 기술

•

장점

◦

빠른 학습 속도

◦

Inference 시간이 짧음

◦

출력된 네트워크 파일의 용량이 작음

◦

과거 파인튜닝 방식보다 결과 퀄리티가 다소 좋은 편임

•

사실상 현재 생성 AI 계에서는 논문보다는 서비스의 이름으로 더 널리 알려짐

참고자료

•

위 영상의 모델은 stable diffusion 1.5 모델을 기반으로 학습됨

사용된 데이터

만들어진 LoRA 모델

모델을 통해 만들어진 결과물들

•

‘LoRA 학습 코랩’에 있는 테스트를 그대로 돌렸을 때 나온 이미지

•

그림체, 몇몇 특징(눈 밑 그림자의 느낌 등)이 생각보다 잘 적용되어 나오는 듯 함

LoRA 모델 + Control Net

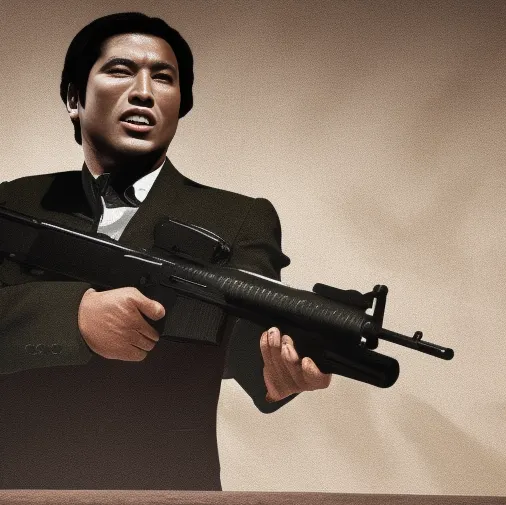

원본 이미지

결과물

•

원본 이미지에 얼굴이 찡그린 표정이다 보니 프롬프트에 배우나 표정 등을 명시 안해주면 갈피를 못잡음(동양인으로 인식. 학습 데이터가 동양인이다 보니 그런 것으로 추정)

잘못된 예시

느낀 점 & 문제점

학습 데이터의 통일성

•

현실적 관점에서 LoRA 모델을 만들 때는 통일성 있는 데이터를 넣어서 학습해야 괜찮은 모델을 만들 수 있음

•

실험적으로 앨범 아트, 여러 작가들의 아트웍 등 약 70개의 데이터를 넣고 학습했을 때는 통일성 없이 넣었다 보니 전혀 쓸모없는 LoRA 모델이 생성됨

과정이 복잡해지고 소요 시간이 길어짐

•

코랩으로 LoRA 모델을 만들다 보니 기본적으로 과정이 복잡해지고 소요 시간이 길어짐

•

이번에 만든 모델에 경우 데이터가 적어서 학습한 시간은 15분 정도이나 전에 실험으로 약 70개의 데이터를 넣었을 때는 1시간 반 정도 소요되었음

•

사실 1시간 30분으로 안정적인 모델 만들 수 있는 것도 대단한 것

코랩 버그

•

LoRA 학습 모델까지 어떻게 만들기 성공했어도 SD에서 img2img, ControlNet, LoRA모델 까지 적용해서 실행하면 확실히 대기 시간이 길어지고 동작을 안 하는 등의 버그가 눈에 띄게 늘어남

•

소요되는 시간과 과정, 노력 등을 비교했을 때 MJ로 베이스가 되는 이미지를 만들고, SD를 통해 수정 과정을 거치는 것이 높은 효율성을 보임