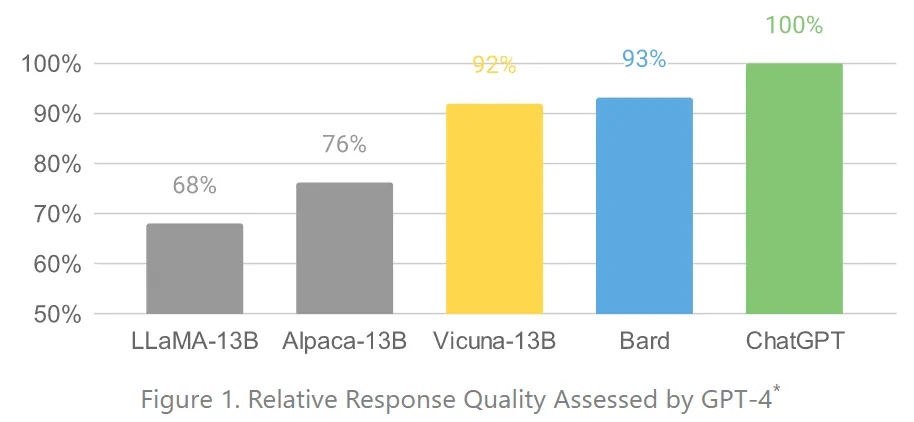

성능은 알파카 보다 한참 떨어짐

•

Dolly 2

◦

회사: databricks

◦

Pythia(EleutherAI) 상업적 사용 가능

◦

finetune 데이터(15k) 회사 인력 이용해 만들어서 공개

◦

12B, 7B, 3B 모델 공개

◦

transformers 패키지 이용해서 쉽게 사용 가능 (7B, 14GB 다운로드, 15GB VRAM) - 12B는 24GB VRAM에서 불가

import torch

from transformers import pipeline

generate_text = pipeline(model="databricks/dolly-v2-7b",

torch_dtype=torch.bfloat16,

trust_remote_code=True, device_map="auto")

generate_text(”What is dolly?”)

Python

복사

•

OpenAssistant

◦

LLama 기반 모델(상업용 사용 X) / Pythia 기반 모델

◦

데모 페이지 제공.

◦

웹사이트 내 게임화로 fine tuning 데이터를 지속적으로 모으고 있음.